A proliferação de discursos de ódio, insultos e ameaças nas plataformas digitais representa um dos desafios mais prementes da era digital contemporânea. A rede social X, anteriormente conhecida como Twitter, tem registado um aumento significativo na disseminação de conteúdos ofensivos e potencialmente perigosos, colocando em causa a segurança e dignidade dos seus utilizadores.

Este fenómeno não se limita apenas a casos isolados, mas configura um padrão sistemático de deficiências na moderação de conteúdos que viola não apenas os próprios termos de serviço da plataforma, mas também disposições legais nacionais e europeias relativas à proteção dos direitos fundamentais, à não discriminação e à prevenção de crimes de ódio.

Metodologia do Estudo:

Esta investigação baseia-se numa análise sistemática de casos documentados de conteúdos de ódio reportados na plataforma X, examinando:

Tipologia dos Conteúdos: Categorização de insultos, ameaças diretas, incitamento ao ódio e discriminação.

Processo de Moderação: Análise das respostas (ou ausência das mesmas) por parte da plataforma.

Tempo de Resposta: Avaliação da celeridade na remoção ou sanções de conteúdos inadequados.

Consistência: Verificação da aplicação uniforme das políticas de moderação.

Impacto e Consequências

As deficiências identificadas no sistema de moderação têm consequências diretas para:

Utilizadores Individuais: Exposição a conteúdos traumatizantes, intimidação e potencial escalada para violência física.

Grupos Vulneráveis: Amplificação de discriminação baseada em origem étnica, orientação sexual, identidade de género, religião ou outras características protegidas.

Sociedade: Degradação do debate público, polarização social, aumento da expressão eleitoral dos partidos populistas e erosão da confiança nas instituições democráticas como tem vindo a ser amplamente demonstrada pela multiplicação de grupos de ódio violentos nos últimos meses.

Objetivos e Finalidade

O presente estudo visa:

1. Documentar de forma sistemática as falhas na moderação de conteúdos na plataforma X (antigo Twitter)

2. Demonstrar o incumprimento de obrigações legais por parte desta plataforma

3. Fundamentar a necessidade de intervenção das autoridades competentes

4. Contribuir para o desenvolvimento de políticas públicas mais eficazes na regulação das plataformas digitais.

1. Participação ao Ministério Público (MP)

Base legal: Código Penal (art. 240.º, 132.º, 180.º, 181.º) e Lei do Cibercrime.

Objetivo: Levar o Ministério Público a investigar e agir criminalmente contra os autores e exigir cooperação do Twitter/X.

Assunto: Queixa por publicação reiterada de conteúdos ilícitos na plataforma X (antigo Twitter)

Eu, Rui Martins, cidadão português, residente em Lisboa, e membro do Movimento pela Democracia Participativa (MDP), venho por este meio apresentar queixa contra a plataforma digital X (antigo Twitter), perante a possível responsabilidade da própria plataforma enquanto facilitadora e inerte moderadora dos seguintes conteúdos:

1. Factos

Nos últimos meses, a plataforma digital X tem alojado e difundido, de forma reiterada e impune, publicações que incluem:

Incitamento ao ódio e à violência contra minorias étnicas, religiosas, sexuais e políticas;

Ameaças diretas e indiretas a ativistas, jornalistas e utilizadores comuns;

Insultos, difamações e linguagem degradante com impacto público.

Estes conteúdos foram devidamente denunciados à própria plataforma por mim e por outros utilizadores, sem que tenha havido remoção ou resposta efetiva.

Exemplos concretos estão listados no anexo 1 (links e capturas de ecrã).

2. Enquadramento Legal

Considero estarem em causa várias infrações criminais:

Art. 240.º do Código Penal – Discriminação e incitamento ao ódio e à violência

Art. 132.º – Ameaças agravadas

Art. 180.º e 181.º – Injuria e difamação

Adicionalmente, pode estar em causa a violação da Lei do Cibercrime (Lei n.º 109/2009), quando os conteúdos são veiculados de forma sistemática em meios digitais.

3. Responsabilidade da Plataforma

Nos termos do Digital Services Act (Regulamento (UE) 2022/2065), o X é uma “Very Large Online Platform” e está obrigado a:

Remover conteúdos ilegais após denúncia;

Implementar mecanismos eficazes de moderação e transparência.

A sua omissão reiterada poderá constituir negligência grave, justificando cooperação judicial internacional.

4. Pedido

Venho pedir por este meio:

Avaliação da responsabilidade da plataforma por facilitação de atos ilícitos;

Cooperação com entidades internacionais para obtenção de dados;

Encaminhamento para entidades reguladoras, se aplicável.

Anexo:

1. Prints e links dos conteúdos

2. Histórico de denúncias à plataforma

Exemplos (URLs) de publicações reportadas à moderação de conteúdos no X e que esta plataforma manteve no ar:

Denúncia à ANACOM – Violação do Digital Services Act pela Plataforma X (antigo Twitter)

Remetente: Rui Martins Lisboa, pelo Portugal pelo Movimento pela Democracia Participativa (MDP)

Destinatário: ANACOM – Autoridade Nacional de Comunicações [DSA Contact Point / Unidade de Supervisão Digital]

Assunto: Denúncia por incumprimento do Regulamento (UE) 2022/2065 – Digital Services Act – pela plataforma X (antigo Twitter)

1. Fundamentação Legal

Nos termos do Regulamento (UE) 2022/2065, em vigor desde fevereiro de 2024, as plataformas classificadas como Very Large Online Platforms (VLOPs), como é o caso do X (Twitter), estão obrigadas a:

Remover conteúdos manifestamente ilegais com celeridade, após notificação fundamentada;

Manter mecanismos eficazes de denúncia e recurso interno;

Prevenir riscos sistémicos, nomeadamente a difusão de conteúdos que atentem contra os direitos fundamentais;

Garantir moderação responsável e transparente, especialmente em matéria de discurso de ódio, ameaças e incitamento à violência.

2. Situação Reportada

Verifica-se, com base em investigação documental e empírica, que a plataforma X tem falhado de forma sistemática no cumprimento destas obrigações, ao manter online conteúdos com fortes indícios de ilegalidade, mesmo após múltiplas denúncias:

Insultos e linguagem degradante contra indivíduos e grupos vulneráveis;

Incitamento ao ódio racial, religioso, político ou identitário;

Ameaças diretas e indiretas contra utilizadores identificáveis, incluindo ativistas e jornalistas;

Ausência de resposta adequada ou remoção eficaz, mesmo após denúncias fundamentadas acompanhadas de prova.

A título de exemplo, apresento alguns conteúdos que foram reportados diretamente à plataforma e mantidos online, com as respetivas URLs e capturas de ecrã (ver Anexos). Em muitos casos, a plataforma respondeu com mensagens automatizadas, recusando a remoção dos conteúdos, mesmo quando estes configuram potenciais ilícitos penais ou violações das suas próprias políticas.

3. Metodologia do Relatório Anexo

O documento técnico anexo baseia-se numa amostra qualificada de casos analisados entre maio e junho de 2025, com os seguintes critérios:

Tipologia do conteúdo: insultos, ameaças, discurso de ódio e incitamento à violência;

Resposta da plataforma: padrão automatizado, ausência de fundamentação e não remoção;

Reincidência: várias contas reincidentes mantêm-se ativas, com histórico de violações;

Risco sistémico: impacto direto sobre utilizadores visados e degradação do ambiente digital.

4. Impacto Social e Digital

As deficiências graves de moderação têm consequências diretas:

Para os utilizadores: exposição a discurso violento, intimidação e assédio reiterado;

Para a sociedade: polarização digital, normalização do ódio, erosão da confiança nas instituições democráticas;

Para a regulação: fragilização da eficácia do DSA se as obrigações legais não forem ativamente fiscalizadas e aplicadas.

5. Pedido Formal à ANACOM

Nos termos da sua competência como entidade reguladora nacional para efeitos do DSA, venho solicitar:

Abertura de processo de verificação de conformidade da plataforma X com as obrigações previstas no Regulamento (UE) 2022/2065;

Avaliação da ineficácia dos mecanismos de denúncia e moderação, à luz do Artigo 16.º e Artigo 17.º do DSA;

Requisição de esclarecimentos à plataforma, sobre os motivos da não remoção dos conteúdos sinalizados;

Adoção de medidas sancionatórias ou corretivas, em caso de incumprimento reiterado;

Encaminhamento para outras autoridades competentes europeias, se aplicável, nomeadamente o Conselho de Coordenadores de Serviços Digitais.

6. Anexos

Exemplos (URLs) de publicações reportadas à moderação de conteúdos no X e que esta plataforma manteve no ar:

Com os melhores cumprimentos,

Rui Martins

Movimento pela Democracia Participativa (MDP)

Lisboa, junho de 2025

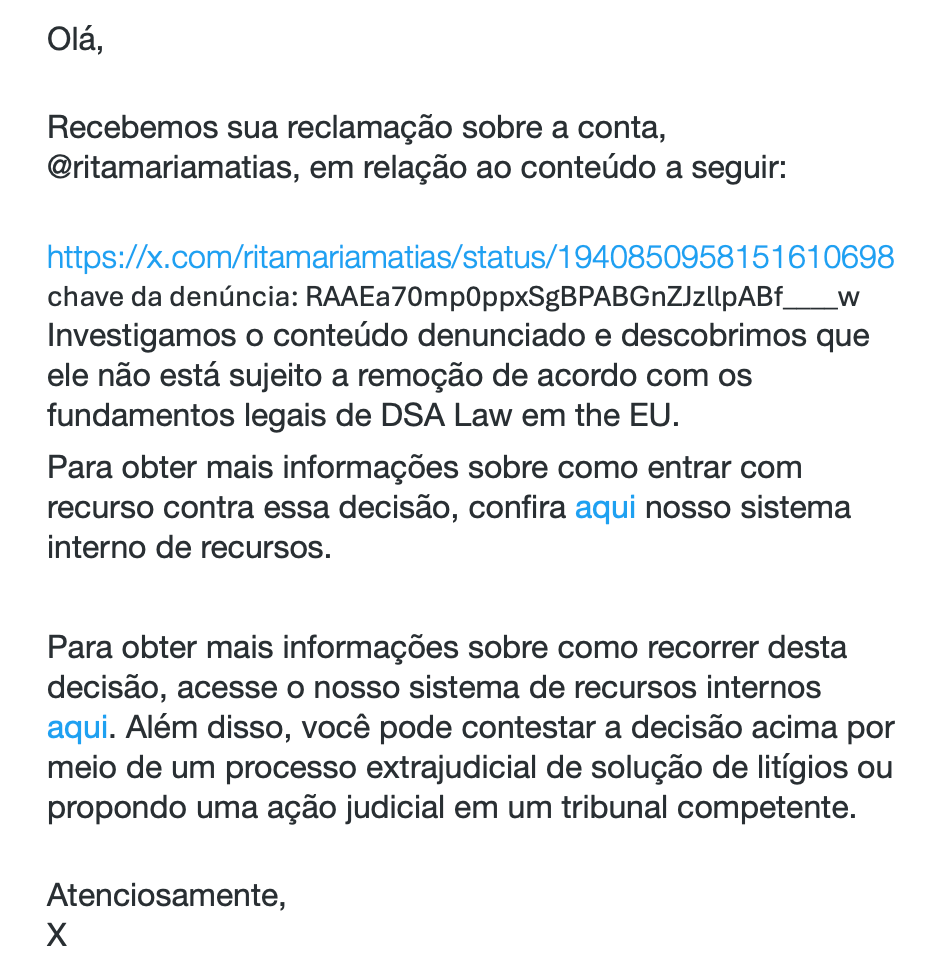

Algumas respostas da “moderação de conteúdos” do X sobre publicações reportadas:

“Recebemos sua reclamação sobre a conta, @velhosportistas, em relação ao conteúdo a seguir:

chave da denúncia: RAAEa3PZJs9dhRgAHABGnZJzllpABf____w

Investigamos o conteúdo denunciado e descobrimos que ele não está sujeito a remoção de acordo com os fundamentos legais de DSA Law em the EU.”

“Depois de analisarmos as informações à disposição, gostaríamos de avisar que Francis61820767 não violou nossas políticas de segurança. Sabemos que esta não é a resposta que você queria, mas se esta conta violar nossas políticas no futuro, notificaremos você.”

“Depois de analisarmos as informações à disposição, gostaríamos de avisar que PajeetCigano não violou nossas políticas de segurança. Sabemos que esta não é a resposta que você queria, mas se esta conta violar nossas políticas no futuro, notificaremos você.”

“Depois de analisarmos as informações à disposição, gostaríamos de avisar que DiogoGo55070552 não violou nossas políticas de segurança. Sabemos que esta não é a resposta que você queria, mas se esta conta violar nossas políticas no futuro, notificaremos você.”

“Depois de analisarmos as informações à disposição, gostaríamos de avisar que Xocolat88830999 não violou nossas políticas de segurança. Sabemos que esta não é a resposta que você queria, mas se esta conta violar nossas políticas no futuro, notificaremos você.”

“Estamos escrevendo para avisar que, depois de revisar as informações à disposição, não descobrimos violação das nossas regras no conteúdo denunciado.”

“Recebemos sua reclamação referente ao seguinte conteúdo da conta @VtorDias418652:

chave da denúncia: RAAEa3pFKrhaR4QAHABGnZJzllpABf____w

De acordo com a legislação vigente, o X está retendo o conteúdo denunciado em France, especificamente com base nos seguintes fundamentos legais: Defamation / Insult.

Para mais informações sobre nossa política de conteúdo retido no país, consulte esta página: https://support.x.com/articles/20169222.”

(recebemos uma resposta idêntica referente ao bloqueio de conteúdos de ódio/insultos na Alemanha o que parece confirmar a tese de que o X é mais eficaz a remover conteúdos de ódio quando se escolhe esta forma de reporte)

Esta análise das respostas da plataforma X (antigo Twitter) a pedidos de moderação de conteúdo revela padrões importantes de comunicação institucional, aplicação (ou não) de políticas internas e os limites da atuação legal da empresa, especialmente dentro do contexto europeu.

Análise:

Padrões nas Respostas da Plataforma

1. Estrutura Padrão e Automatizada

As mensagens seguem um modelo padronizado e automatizado, indicando respostas pré-formatadas com mínimas variações:

Introdução (“Olá, depois de analisarmos…”)

Decisão sobre a violação ou não de políticas

Orientação sobre bloqueio de contas

Resumo das políticas de segurança

Encerramento com convite à nova denúncia, se necessário

Esse padrão sugere uma abordagem automatizada ou semi-automatizada para denúncias de conteúdo, com possível envolvimento limitado de revisão humana, salvo exceções legais.

Diferenciação Legal e Política Interna

1. Casos Baseados em Legislação (DSA/EU e Leis Nacionais)

Exemplo: No caso da conta @velhosportistas, o conteúdo é considerado não passível de remoção segundo o DSA da União Europeia.

Já o conteúdo da conta @VtorDias418652 foi retido especificamente em França, com base em legislação de “difamação ou insulto”.

Ou seja, o X reconhece obrigações legais específicas de jurisdições nacionais — especialmente no espaço europeu — o que demonstra algum alinhamento com o Digital Services Act (DSA), permitindo que conteúdos sejam geobloqueados (removidos apenas em certos países) mesmo que não violem as regras globais da plataforma.

Respostas de Não-Violação

As respostas referentes às contas Francis61820767, PajeetCigano, DiogoGo55070552, Xocolat88830999 e outras seguem uma lógica similar:

1. Não Violação

A plataforma conclui que não houve violação das políticas de segurança.

As denúncias são “bem-vindas”, mas não resultam em punições ou remoção.

2. Recomendações de Ação Individual

3. Sugestão para o denunciante bloquear a conta ofensora.

4. Reforço da autonomia do usuário em sua própria experiência digital.

3. Resumo das Políticas de Segurança

Reforçam publicamente que as seguintes ações são proibidas:

Ameaças e assédio

Promoção de violência ou suicídio

Exploração sexual de menores

Terrorismo

Nota crítica: O resumo serve como reforço institucional, mas a aplicação efetiva parece falhar aos olhos de quem denuncia, já que o conteúdo permanece disponível.

Mecanismos de Recurso e Contestação

A plataforma informa, especialmente em conteúdos analisados sob o prisma legal (como no caso da França, Alemanha ou da UE em geral), que é possível:

1. Recorrer internamente

2. Procurar resolução extrajudicial

3. Iniciar ação judicial

Isto demonstra que o X fornece um mínimo de devido processo digital, como exigido por normas europeias, mas a experiência para o utilizador comum ainda é bastante opaca e pouco responsiva.

Considerações Críticas e Potenciais Problemas

Falta de Justificações Detalhadas

As respostas não explicam porque é que o conteúdo não violou as regras. Isto frustra os utilizadores da plataforma e reduz a confiança na moderação o que, a curto prazo, reduz a quantidade de reportes de eventuais violações e degrada cada vez a qualidade de conteúdos e multiplica o discurso de ódio e as ameaças na plataforma.

Risco de Subnotificação de Conteúdo Abusivo

Ao não remover conteúdos que parecem violar diretrizes, a plataforma pode estar normalizando o discurso abusivo ou o “limiar da violência”.

Soluções Reativas, Não Preventivas

A recomendação de “bloquear” desvia a responsabilidade da plataforma para o utilizador, o que é criticável do ponto de vista de bem-estar digital coletivo.

Conclusão

As respostas do X refletem uma combinação de protocolos automatizados, moderação limitada ou automatizada e o cumprimento mínimo (ou nulo) de obrigações legais, sobretudo no espaço europeu. Embora exista um mecanismo institucional e jurídico, a experiência do utilizador do X (antigo Twitter) perante conteúdo abusivo ou ofensivo continua a ser muito insatisfatória, com pouco espaço para diálogo e revisão transparente.

Deixe uma resposta para ANACOM aceita queixa e encaminha para o coordenador dos serviços digitais da Irlanda, Coimisiún na Meán: “Violação Sistemática do Digital Services Act pela Plataforma X (antigo Twitter)” – MDP: Movimento pela Democracia Participati Cancelar resposta